Jak zainstalować Hadoop na Ubuntu 18.04 Bionic Beaver Linux

- 1689

- 14

- Laura Zygmunt

Apache Hadoop to struktura typu open source używana do pamięci rozproszonej, a także rozproszone przetwarzanie dużych zbiorów danych na temat klastrów komputerów, które działają na twardości towarowej. Hadoop przechowuje dane w Hadoop rozproszonym systemie plików (HDFS), a przetwarzanie tych danych odbywa się za pomocą MapReduce. Przędza zapewnia API do żądania i przydzielania zasobów w klastrze Hadoop.

Framework Apache Hadoop składa się z następujących modułów:

- Hadoop Common

- Hadoop rozproszony system plików (HDFS)

- PRZĘDZA

- MapReduce

W tym artykule wyjaśniono, jak zainstalować Hadoop wersję 2 na Ubuntu 18.04. Zainstalujemy HDFS (Namenode i DataNode), Yarn, MapReduce w klastrze pojedynczego węzła w trybie Pseudo rozproszonym, który jest rozproszony symulacja na jednym komputerze. Każdy demon Hadoop, taki jak HDFS, przędza, mapier. będzie działał jako osobny/indywidualny proces Java.

W tym samouczku nauczysz się:

- Jak dodać użytkowników do środowiska Hadoop

- Jak zainstalować i skonfigurować Oracle JDK

- Jak skonfigurować SSH bez hasła

- Jak zainstalować Hadoop i skonfigurować niezbędne powiązane pliki XML

- Jak rozpocząć klaster Hadoop

- Jak uzyskać dostęp do interfejsu internetowego Namenode i ResourceManager

Interfejs użytkownika Namenode Web.

Interfejs użytkownika Namenode Web. Zastosowane wymagania i konwencje oprogramowania

| Kategoria | Wymagania, konwencje lub wersja oprogramowania |

|---|---|

| System | Ubuntu 18.04 |

| Oprogramowanie | Hadoop 2.8.5, Oracle JDK 1.8 |

| Inny | Uprzywilejowany dostęp do systemu Linux jako root lub za pośrednictwem sudo Komenda. |

| Konwencje | # - Wymaga, aby podane polecenia Linux są wykonywane z uprawnieniami root bezpośrednio jako użytkownik root lub za pomocą sudo Komenda$ - Wymaga, aby podane polecenia Linux zostały wykonane jako zwykły użytkownik niepewny |

Inne wersje tego samouczka

Ubuntu 20.04 (Focal Fossa)

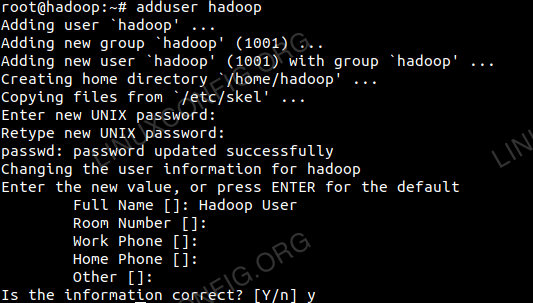

Dodaj użytkowników środowiska Hadoop

Utwórz nowego użytkownika i grupę za pomocą polecenia:

# Dodaj użytkownika

Dodaj nowego użytkownika do Hadoop.

Dodaj nowego użytkownika do Hadoop.

Zainstaluj i skonfiguruj Oracle JDK

Pobierz i wyodrębnij archiwum Java pod /optować informator.

# CD /opt # TAR -xZVF JDK-8U192-Linux-X64.smoła.GZ

Lub

$ tar -xzvf JDK-8U192-Linux-x64.smoła.GZ -C /Opt

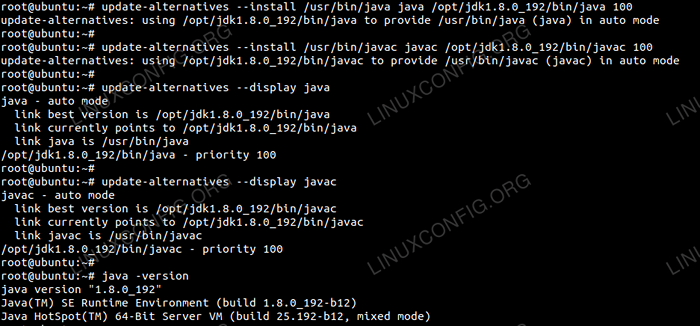

Aby ustawić JDK 1.8 Aktualizacja 192 Jako domyślny JVM użyjemy następujących poleceń:

# aktualizacja-alternatywy-install/usr/bin/java java/opt/jdk1.8.0_192/bin/java 100 # aktualizacja-alternatywy-install/usr/bin/javac javac/opt/jdk1.8.0_192/bin/javac 100

Po instalacji w celu sprawdzenia Java została pomyślnie skonfigurowana, uruchom następujące polecenia:

# aktualizacja-alternatywy--Display Java # aktualizacja-alternatywy-Display Javac

Instalacja i konfiguracja OracleJDK.

Instalacja i konfiguracja OracleJDK. Skonfiguruj SSH bez hasła

Zainstaluj otwarty serwer SSH i otwórz klienta SSH za pomocą polecenia:

# sudo apt-get install openSsh-server openSsh-client

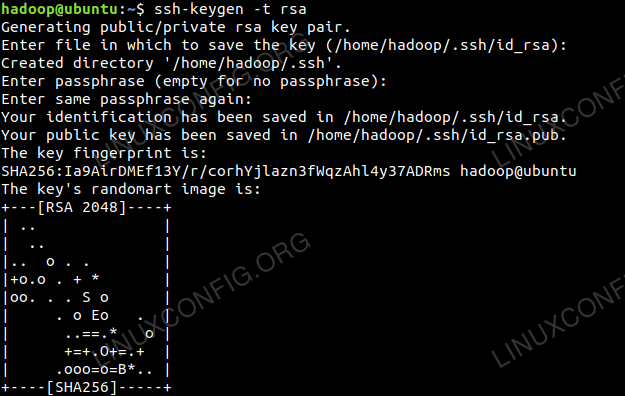

Generuj pary kluczy publicznych i prywatnych z następującym poleceniem. Terminal będzie monitowany o wprowadzenie nazwy pliku. Naciskać WCHODZIĆ i postępuj. Po tym skopiowaniu formularza kluczy publicznych id_rsa.pub Do autoryzowane_keys.

$ ssh -keygen -t rsa $ cat ~/.ssh/id_rsa.pub >> ~/.ssh/autoryzowane_keys

Konfiguracja SSH bez hasła.

Konfiguracja SSH bez hasła.

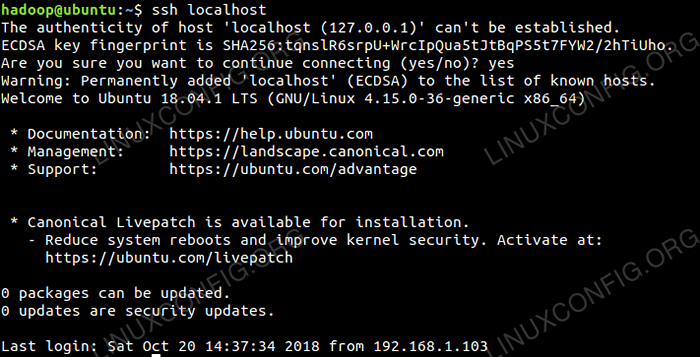

Sprawdź konfigurację SSH bez hasła za pomocą polecenia:

$ ssh localhost

Kontrola SSH bez hasła.

Kontrola SSH bez hasła.

Zainstaluj hadoop i skonfiguruj powiązane pliki XML

Pobierz i wyodrębnij Hadoop 2.8.5 z oficjalnej strony internetowej Apache.

# tar -xzvf Hadoop -2.8.5.smoła.GZ

Konfigurowanie zmiennych środowiskowych

Edytuj Bashrc Dla użytkownika Hadoop poprzez konfigurowanie następujących zmiennych środowiskowych Hadoop:

Eksport hadoop_home =/home/hadoop/hadoop-2.8.5 Eksportuj hadoop_install = $ hadoop_home eksport hadoop_mapred_home = $ hadoop_home eksport hadoop_common_home = $ hadoop_home eksport hadoop_hdfs_home = $ hadoop_home export yarn_home = $ hadoop_home export hadoop_common_lib_native_dir = $ hadoop_home/lib/lib/$ export export export $ = export export $/$ hadoop_ hadoop_ hadoop_ hadoop_ hadoops export pather = export thast/lib/$ export thast = export thast/ Eksport Hadoop_Opts = "-Djava.biblioteka.ścieżka = $ hadoop_home/lib/Native " Źródło .Bashrc W bieżącej sesji logowania.

$ źródło ~/.Bashrc

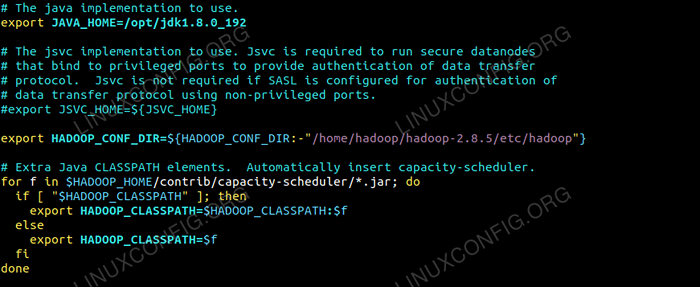

Edytuj Hadoop-env.cii plik, który jest w /etc/hadoop wewnątrz katalogu instalacji Hadoop i dokonaj następujących zmian i sprawdź, czy chcesz zmienić inne konfiguracje.

Eksport java_home =/opt/jdk1.8.0_192 Eksport Hadoop_conf_dir = $ Hadoop_conf_dir:-"/home/hadoop/hadoop-2.8.5/etc/hadoop "  Zmiany w Hadoop-ENV.plik sh.

Zmiany w Hadoop-ENV.plik sh. Zmiany konfiguracji w witrynie rdzeniowym.plik XML

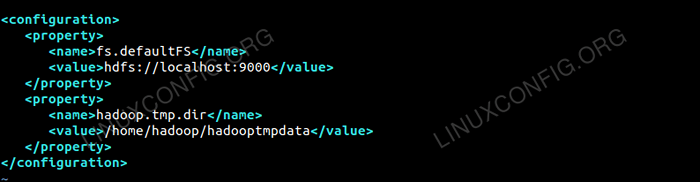

Edytuj Site Core.XML z vim lub możesz użyć dowolnego z redaktorów. Plik jest poniżej /etc/hadoop wewnątrz Hadoop Directory Home i dodaj następujące wpisy.

fs.defaultfs HDFS: // Localhost: 9000 Hadoop.TMP.reż /home/hadoop/hadooptmpdata Ponadto utwórz katalog poniżej Hadoop Folder domowy.

$ mkdir hadooptmpdata

Konfiguracja dla rdzenia.plik XML.

Konfiguracja dla rdzenia.plik XML. Zmiany konfiguracji w witrynie HDFS.plik XML

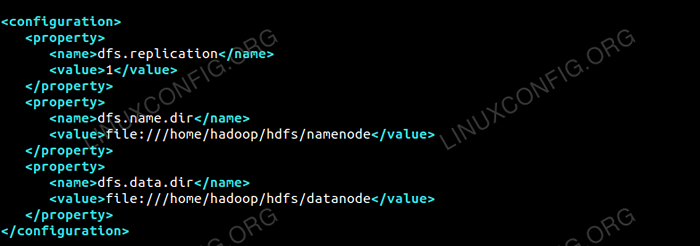

Edytuj Site HDFS.XML który jest obecny w tej samej lokalizacji i.mi /etc/hadoop wewnątrz Hadoop katalog instalacyjny i utwórz Namenode/DataNode katalogi pod Hadoop Katalog domów użytkownika.

$ mkdir -p hdfs/namenode $ mkdir -p hdfs/datanode

DFS.Replikacja 1 DFS.nazwa.reż Plik: /// home/hadoop/hdfs/namenode DFS.dane.reż Plik: /// home/hadoop/hdfs/datanode  Konfiguracja dla witryny HDFS.plik XML.

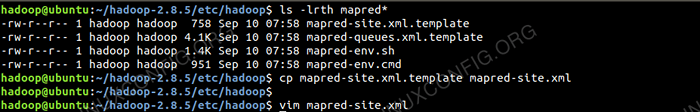

Konfiguracja dla witryny HDFS.plik XML. Zmiany konfiguracyjne w witrynie Mapred.plik XML

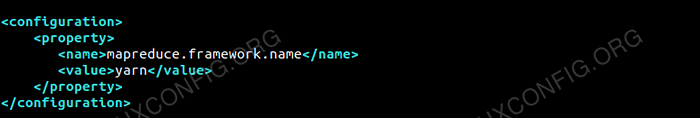

Skopiuj Mapred.XML z Mapred.XML.szablon za pomocą CP polecenie, a następnie edytuj Mapred.XML położone w /etc/hadoop pod Hadoop Directory inpnelation z następującymi zmianami.

$ CP Mapred Site.XML.szablon Mapred-Site.XML

Tworzenie nowego witryny Mapred.plik XML.

Tworzenie nowego witryny Mapred.plik XML. MapReduce.struktura.nazwa przędza  Konfiguracja dla Mapred-Site.plik XML.

Konfiguracja dla Mapred-Site.plik XML. Zmiany konfiguracji w witrynie przędzy.plik XML

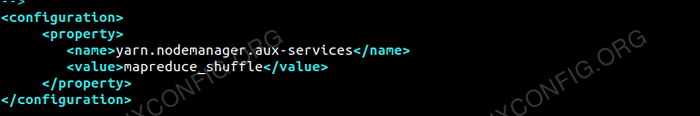

Edytować strona przędzy.XML z następującymi wpisami.

MapReduceyarn.Nodemanager.Usługi aux MAPREDUCE_SHUFLE  Konfiguracja dla strony przędzy.plik XML.

Konfiguracja dla strony przędzy.plik XML. Rozpoczynając klaster Hadoop

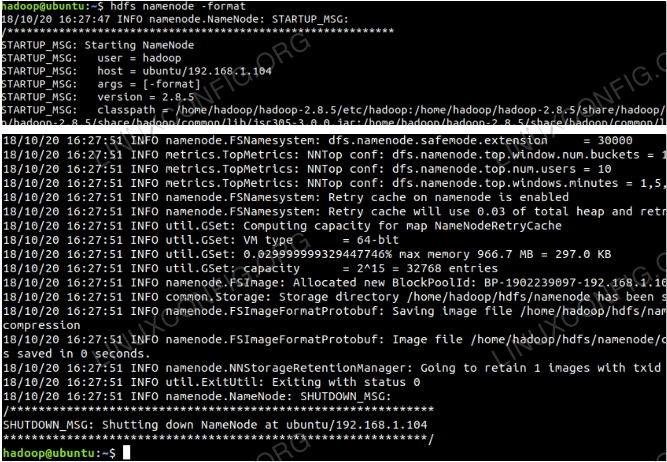

Sformatuj nazanodę przed użyciem go po raz pierwszy. Jako użytkownik HDFS uruchamia poniższe polecenie, aby sformatować nazwy nazwy.

$ hdfs namenode -Format

Sformatuj nazewnictwo.

Sformatuj nazewnictwo.

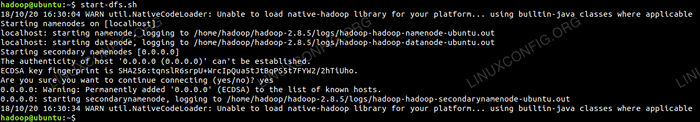

Po sformatowaniu nazwy, a następnie uruchom HDFS za pomocą start-DFS.cii scenariusz.

Uruchamianie skryptu startupu DFS, aby uruchomić HDFS.

Uruchamianie skryptu startupu DFS, aby uruchomić HDFS.

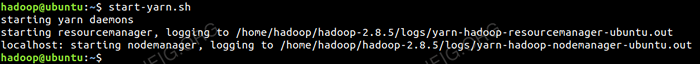

Aby uruchomić usługi przędzy, musisz wykonać skrypt początkowy przędzy i.mi. Start-Yarn.cii

Rozpoczęcie skryptu uruchamiania przędzy, aby uruchomić przędzę.

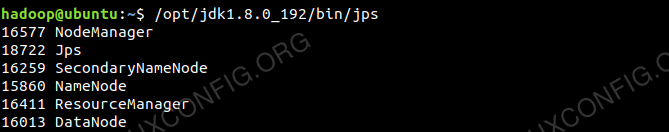

Rozpoczęcie skryptu uruchamiania przędzy, aby uruchomić przędzę. Aby sprawdzić, czy wszystkie usługi/demony Hadoop zostały uruchomione z powodzeniem, możesz użyć JPS Komenda.

/opt/jdk1.8.0_192/bin/JPS 20035 SecondaryNamenode 19782 DataNode 21671 JPS 20343 NodeManager 19625 Namenode 20187 ResourceManager  Wyjście Demonów Hadoop z polecenia JPS.

Wyjście Demonów Hadoop z polecenia JPS.

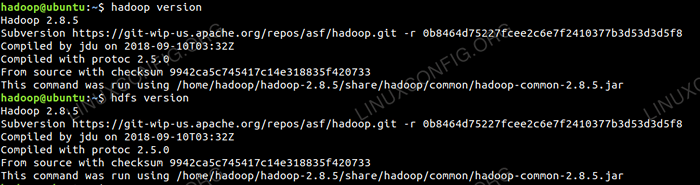

Teraz możemy sprawdzić bieżącą wersję Hadoop, której możesz użyć poniżej polecenia:

Wersja $ Hadoop

Lub

Wersja $ HDFS

Sprawdź wersję Hadoop.

Sprawdź wersję Hadoop.

Interfejs wiersza poleceń HDFS

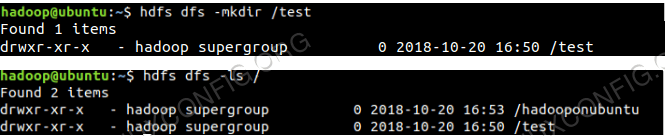

Aby uzyskać dostęp do HDF i utworzyć niektóre katalogi DFS, możesz użyć HDFS CLI.

$ hdfs dfs -mkdir /test $ hdfs dfs -mkdir /hadooponubuntu $ hdfs dfs -ls /

Tworzenie katalogu HDFS za pomocą HDFS CLI.

Tworzenie katalogu HDFS za pomocą HDFS CLI.

Uzyskaj dostęp do nazwy i przędzy z przeglądarki

Możesz uzyskać dostęp zarówno do interfejsu internetowego dla Namenode, jak i Menedżer zasobów przędzy za pośrednictwem dowolnej przeglądarki, takiej jak Google Chrome/Mozilla Firefox.

Namenode Web interfejs - http: //: 50070

Interfejs użytkownika Namenode Web.

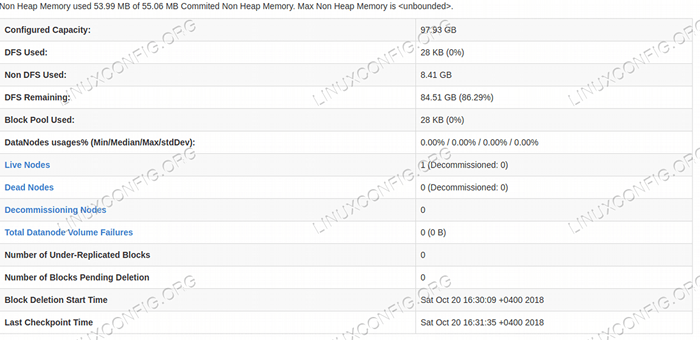

Interfejs użytkownika Namenode Web.  Szczegóły HDFS z interfejsu użytkownika Namenode Web.

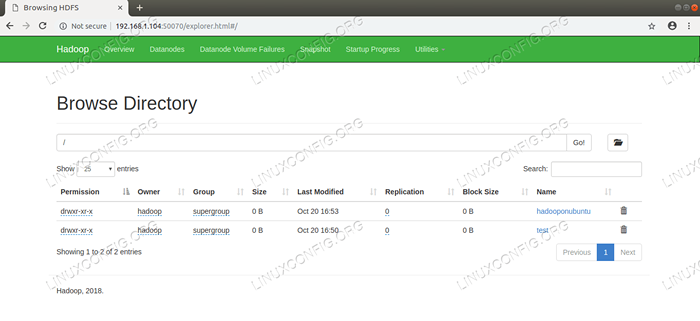

Szczegóły HDFS z interfejsu użytkownika Namenode Web.  HDFS Directory Browing za pośrednictwem interfejsu użytkownika Namenode Web.

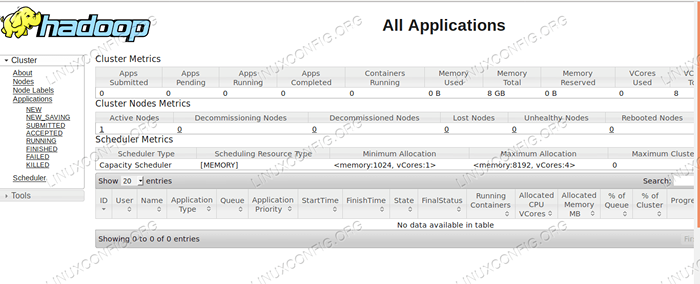

HDFS Directory Browing za pośrednictwem interfejsu użytkownika Namenode Web. Interfejs internetowy YARN Resource Manager (RM) wyświetli wszystkie uruchomione zadania w bieżącym klastrze Hadoop.

Interfejs internetowy menedżera zasobów - http: //: 8088

Interfejs użytkownika internetowego menedżera zasobów.

Interfejs użytkownika internetowego menedżera zasobów. Wniosek

Świat zmienia sposób, w jaki obecnie działa, a Big-Data odgrywa ważną rolę w tej fazie. Hadoop to ramy, które ułatwia nasz życie podczas pracy nad dużymi zestawami danych. Istnieją ulepszenia na wszystkich frontach. Przyszłość jest ekscytująca.

Powiązane samouczki Linux:

- Ubuntu 20.04 Hadoop

- Rzeczy do zainstalowania na Ubuntu 20.04

- Jak utworzyć klaster Kubernetes

- Jak zainstalować Kubernetes na Ubuntu 20.04 Focal Fossa Linux

- Rzeczy do zrobienia po zainstalowaniu Ubuntu 20.04 Focal Fossa Linux

- Jak zainstalować Kubernetes na Ubuntu 22.04 JAMMY Jellyfish…

- Rzeczy do zainstalowania na Ubuntu 22.04

- Jak pracować z WooCommerce Rest API z Pythonem

- Jak zarządzać klastrami Kubernetes z Kubectl

- Wprowadzenie do automatyzacji, narzędzi i technik Linuksa

- « Jak zainstalować Android Studio na Manjaro 18 Linux

- Jak zainstalować Google Chrome na Manjaro 18 Linux »